Hoy día Matt ha comenzado a responder en su blog a las preguntas de los SEO’s que se habia dispuesto a responder (ver nota).

Como las respuestas son MUY importantes para los que están interesados en posicionar sus páginas en Google las voy a transcribir a continuación al español:

P: Se ha propagado Bigdaddy por completo?

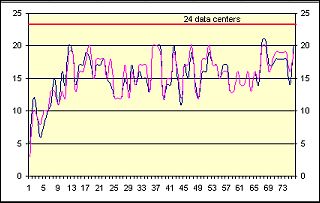

R: Si, creo que cada uno de los data centers ya tiene el upgrade de la infraestructura de software Bigdaddy.

P: Cuál es la historia sobre el Mozilla Googlebot? Es esto lo que envía Bigdaddy?

Si, así lo creo. Probablemente Uds. verán menos al viejo googlebot, que tiene como user-agent “Googlebot/2.1 (+http://www.google.com/bot.html)”. Creo que la nueva infraestructura Bigdaddy tiene un nuevo robot, cual es Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)”

P: Llevaste a Emmy a San Fransisco?

R: Nop, Emmy es una gata casera, no le gusta viajar

P: Algunas novedades sobre los sitios que muestran resultados suplementarios?

R: A fines de la ultima semana se han hecho algunos cambios con escaneos (crawlings) adicionales para mostrar mas de estos sitios, pero todavía va ha tomar algún tiempo (algunos días más) para poder mostrarlos en el índice. Echaré una ojeada a aquellos sitios que la gente me ha mencionado.

P: El parámetro RK ha sido completamente desactivado, o podemos esperar de verlo nuevamente?

A: No creo que el parámetro RK vuelva a tener un valor diferente de 0.

P: Que es el parámetro RK?

A: Es el parámetro que se puede ver en el Google Toolbar query. Alguna gente fuera de Gogle ha especulado que este valor era el PageRank actual (live), que este valor difería entre Bigdaddy y la antigua infraestructura, etc.

P: Ahora que Bigdaddy ya esta afuera, habrá una exportación del PageRank (quiere decir actualización de la barrita verde) pronto? y ahora en Bigdaddy se van a estabilizar los aspectos relacionados al PR?

A: Preguntaré por aquí sobre esto. Si es que no existen obstáculos logísticos, voy a preguntar si podemos hacer visible el PageRank en las próximas semanas. Y espero que a medida de que Bigdaddy se estabilice en todo lado, la variación del PR en la Toolbar va ha terminar.

P: El data center http://64.233.185.104/ trabaja en forma diferente a los otros. Lo note hace unas horas… Como encaja este DC en el esquema?

R: Ojos agudos, g1smd. No me sorprendería. A medida de que Bigdaddy se enfríe, eso nos libera para hacer nuevas/otras cosas.

P: No es una pregunta… Consigue una PSP

A: He conseguido una hoy día…..

(Algunas preguntas y respuestas irrelevantes al tema)

P: Por qué focalizas mucho tu atención en los SEOs y no en los webmasters que haces páginas web de calidad?

R: Yo creo que este tema es algo personal, porque yo paso mucho tiempo observando SPAM. Muchas otras personas se enfocan a ayudar a webmasters en general. Como el equipo de sitemaps, por ejemplo. He comenzado en hacer post ‘Consejos para SEOs’ y no ‘Errores de los SEOs’ Pero tienes razón. Personalmente debería tener un recordatorio para mantenerme enfocado en sitios que tienen calidad. Gracias por mencionarlo.

Q: Mi sitemap tiene 1320 URLs. Y ya hacen más de 2+ años que todas mis páginas no pueden ser indexadas. Estoy olvidándome de algo?

R: Uno de los clásicas estrategias del escaneo (crawling) de Google es usar el valor del PageRank de tus páginas. Solamente porque tu sitio tiene un par de años (o por que has enviado un sitemap), no significa que automáticamente todas las páginas de tu sitio serán escaneadas. En general, obteniendo enlaces buenos y de calidad nos ayudaría probablemente a escanear tu sitio mas profundamente. Tu deberías mirar las URLs que hasta ahora no han sido indexadas. Talvez tienen parámetros (nosotros preferimos URLs con 1-2 parámetros)? Existe un archivo robots.txt. Es posible fácilmente alcanzar URLs no indexadas siguiendo enlaces estáticos de texto (no Flash, JavaScripts, cookies, frames, etc. tienes algo así?). Esto seria lo que recomendaría controlar.

P: Cuándo modifico robots.txt para excluir archivos que han sido escaneados, cuanto tiempo toma hasta que estos sean borrados del índice? Tal vez la respuesta depende del PR del sitio y de la frecuencia del escaneo?

A: Esta en función a la frecuencia con la cual es sitio es escaneado. Yo creo que en el pasado, cada escaneo de varios de cientos de páginas o tras varios días, el bot chequea nuevamente robots.txt. Cabe mencionar que para los resultados suplementarios, debes re-escanar para saber que ha sucedido con esas páginas para que el robots.txt haga efecto en esas páginas. Si estas seguro que quieres que esas páginas no aparezcan mas, puedes usar la herramienta para borrar URLs por seis meses. Pero yo seria muy cuidadoso con esta herramienta, a no ser que seas experto. Si es que cometes un error (por ejemplo) y borras todo el sitio, esta es tu responsabilidad. Algunas veces Google puede revertir esto, pero no lo garantizamos.

P: Yo quisiera buscar por código HTML y observar como se posiciona

R: Yo también quisiera. Indexar partes invisibles como puntuación, JavScript, HTML seria grandioso, pero abultaría el tamaño del índice. Cada vez que consideras una nueva característica (por ejemplo la numeración de los resultados) tienes que valorar el costo de tener un índice mas grande con el beneficio de esta funcionalidad. Creo que no ofreceríamos algo así en un futuro próximo.

(Preguntas y respuestas sin mucha relevancia)

P: Si alguien ofrece vender espacio en su sitio (o considera comprar en otro) seria una buena idea de colocar la etiqueta NOFOLLOW para generar trafico por los anuncios y no aparentar una venta de enlaces para manipular el PR?

R: Si, si vendes enlaces, deberías marcarlos con la etiqueta nofollow. El no hacerlo puede afectar tu reputación en Google.

P: En sitios dirigidos a publico internacional con el mismo contenido (con alta calidad) en diferentes idiomas, es mejor usar varios TLDs como mydomain.com, mydomain.de, mydomain.fr, etc. o en subdominios como en.mydomain.eu, de.mydomain.eu, fr.mydomain.eu, o algo así mydomain.com/en, mydomain.com/de, mydomain.com/fr?

R: Buena pregunta. Si solo tienes un pequeño numero de páginas, yo comenzaría con los subdominios, p.e. de.mydomain.eu o de.mydomain.com Después de que has desarrollado una sustanciosa presencia o una gran cantidad de páginas en cada idioma, haría sentido de desarrollar en dominios separados.

P: Algunos resultados por qué dominios IDN no muestran PageRank?

R: He visto también algunas veces esto también, pero lo voy a revisar. Pienso que hay un problema de normalización en algún lugar de la cadena (pathway) de la barra del PageRank.

P: Será posible de adicionar un rango de fechas a las búsquedas? Yo obtendría 91,000.000 resultados, pero los primeros 200 tendrían 2-3 años de antigüedad. Desearía limitar los resultados a no más de 6-12 meses

R: Revisa la opción de busquedas avanzadas. Tara Calashian hizo cosas interesantes sobre esto. Google Hacks es un lindo libro que puedes leer para esto.

P: Que hay acerca del problema de comparación de directorios y shops con spam que sobre escribe páginas reales?

A: Fair Feedback. Lo mismo he escuchado últimamente de un Googler también. Algunas veces pensamos sobre el spam estrictamente como texto oculto, cloacking, etc. Pero los usuarios piensan sobre spam como ruido: Cosas que ellos no desean. Si ellos están tratando de obtener información, solucionar un problema, leer artículos, etc. entonces estos sitios no son de ayuda.

P: Esta planeando visitar/hablar en el Reino Unido en un futuro próximo?

R: Lamentablemente, no. Solo puedo asistir a 4-5 conferencias al año.

P: Una de las cosas que interesa a la gente es cuales son las intenciones Post Bigdaddy? Arreglos (fixes), temas de spam. regeneración de indices puros, resultados suplementarios, actualización de PR, BL, etc.

A: No puedo dar un cronograma (por ejemplo, escalar la comunicación en Abril, mas trabajos en canónicas en Mayo) porque las prioridades puede cambiar, especialmente por aspectos de las maquinas, propagación de nuevos binarios, desarrollo del webspam, etc. A corto plazo no me sorprendería de ver pronto un cambio en los resultados suplementarios y PageRank visibles diferentes en las próximas semanas.

(Preguntas y respuestas sin relevancia)