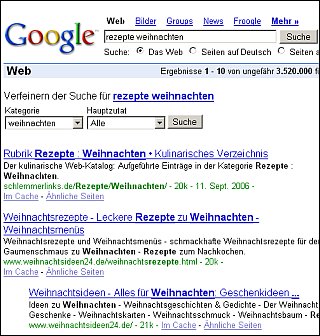

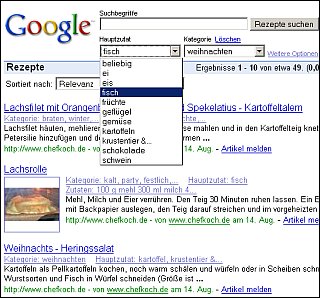

Como ya es bien conocido, el trabajo de optimización de páginas web en buscadores (SEO) no puede ser considerado como una ciencia. Es más bien, una tarea empírica que esta guiada por los resultados que se observan en el índice o ranking del buscador al colocar datos (una página web) en una caja negra (el algoritmo del buscador). Esta situación se puede apreciar más claramente en el siguiente diagrama:

Proceso de optimización de páginas web

En el transcurso de los años los SEOs han aprendido – observando los resultados del índice y realizando diferentes experimentos – en forma general el funcionamiento de los algoritmos de los buscadores.

Usando estas observaciones, los SEOs han creado unas serie de reglas para poder manipular la posición de una página web en el índice de los buscadores. Estas reglas se pueden por lo general dividir en 2 clases:

Optimización On Page

Comprenden todas las reglas de optimización que se pueden realizar directamente en la página misma. Todas estas reglas pueden ser realizadas por el webmaster. Entre estas se cuentan por ejemplo:

- definición de la URL de la página

- definición del título de la página web

- definición de los diferentes meta tags como ser keywords y description

- definición del contenido usando las palabras claves en forma adecuada en todo el texto para aumentar su densidad en el contenido, así como también usando los tags de HTML (h1, h2, b, etc.) para mostrar la relevancia de las palabras claves

- estructuración de los enlaces internos para insinuar la importancia de la página en toda la web

- Y otras reglas de menor importancia

Optimización Off Page

Comprenden todas las reglas que se usan para optimizar una página pero que se encuentran fuera de la web y que en realidad no están bajo control del webmaster. Y justamente por esto, por ejemplo Google le da más importancia. Entre estas reglas se tienen:

- El numero de enlaces que apuntan a la página, y que es un factor para el calculo del PageRank de Google que definía en el algoritmo original la popularidad de una página

- Enlaces de páginas con autoridad y de temas relacionados a la página

- El porcentaje de visitas recurrentes que es una métrica de la calidad del contenido

- Y otras reglas con menor relevancia

Solamente, siguiendo estas reglas – mas o menos al pie de la letra – era posible con relativa facilidad manipular los resultados del ranking de los buscadores y alcanzar las primeras posiciones.

Justamente en los últimos días Matt Cutts, un empleado de Google que hace de comunicador inoficial entre Google y los webmasters, ha presentado una serie de videos en los que responde a muchas de estas preguntas básicas:

– Sesiones 1, 2, 3

– Sesiones 4, 5, 6

El uso de estas reglas también fue aprovechado por black hat SEOs para posicionar sitios con contenidos basura, SPAM que comenzó a mediados de los años 90. Por este motivo, Google comenzó a modificar sus algoritmos para limpiar su índice de basura.

Se fueron adicionando una serie de nuevos filtros, como por ejemplo la edad de los dominios. Los dominios nuevos, que podrían haber sido creados por spamers, son inicialmente penalizados en el ranking y no pueden alcanzar las primeras posiciones para las diferentes palabras claves.

La cúspide de estos cambios en los algoritmos de Google se alcanzo con la implementación de una nueva infraestructura (no se sabe a ciencia cierta sí este termino se refiere a nuevo hardware, base de datos, o simplemente a los algoritmos) que se la llamo Bigdaddy y que comenzó a propagarse en Enero 2006 y concluyo a fines de Marzo 2006.

Después de la finalización de Bigddady, el mundo SEO ya no es el mismo: A pesar de que las reglas mencionadas anteriormente aun tienen parcialmente vigencia, ya no es posible posicionar una página tan fácilmente.

Mas aun, actualmente tampoco es posible obtener información confiable sobre las razones de las bajadas y subidas de las páginas en el ranking de estos días.

Solamente se ha podido percibir que el 27.06.06 y el 27.07.06 actualizaciones del índice han afectado a muchos sitios. Estos días estuve revisando diversos foros en diferentes idiomas, y solo se puede leer que muchas páginas han caído considerablemente en el ranking, pero nadie puede dar una explicación plausible del porqué.

Parece que los filtros que se han usado en estas actualizaciones, o como muchos las denominan index refresh, afectan a sitios completos y no a páginas aisladas. Parecería ser que los sitios con contenidos antiguos y estáticos son los afectados, mientras que sitios que actualizan sus contenidos regularmente se han mantenido en sus posiciones.

La única alternativa que por ahora queda es la diversificación del portafolio de proyectos para que se puedan de alguna manera equilibrar tanto las caídas como las subidas en las posiciones.

Si es que alguien tiene alguna sugerencia o teoría sustentable, todos los comentarios son bienvenidos.